リベリオンNPUで直接経験したLLM推論の新たな可能性

2025年8月に開催されたvLLM Korea Meetupに続き、10月29日にはリベリオンとスクイーズビーツ(SqueezeBits)の共催で『vLLM Hands-on Workshop』を開催しました。韓国のNPU企業がAI開発者を招待し、実習中心のワークショップを行ったのは今回が初めてです。この場を通じて、参加者は普段なかなか手に触れる機会がなかったNPUとvLLM基盤の推論を自ら経験できる貴重な時間となりました。

NPUへの疑問を解消する機会

ワークショップ後に行われた満足度調査の結果、参加者全員が「満足する」以上を回答として選びました。イベントの中で最も印象に残ったことは「リベリオンNPUを利用して、vLLMを自分の手で動かしてみた経験だ」と答えました。参加者は「PyTorchベースのコードフローに慣れている人なら、別途で環境設定をしなくても実習だけですぐ使いこなせる」と評価しました。また、今回のワークショップでは、これまで抱えていたコア技術に関する疑問を解消し、その答えを得る機会となりました。

- NPUを導入するには、既存のコードやMLOpsのパイプラインを大きく変える必要があるのか?

- Hugging Face、PyTorch、vLLMに続く開放型AI技術スタックとNPUの統合レベルはどうなのか?

- どうすれば複雑なMoEモデルの分散推論をNPUでも効率的に処理できるのか?

これをきっかけに参加者はリベリオンNPUが開発者に配慮しながらも、高効率のAI推論インフラとして急速に発展していることを自ら確かめることができました。

使い慣れた開発者体験(DX)

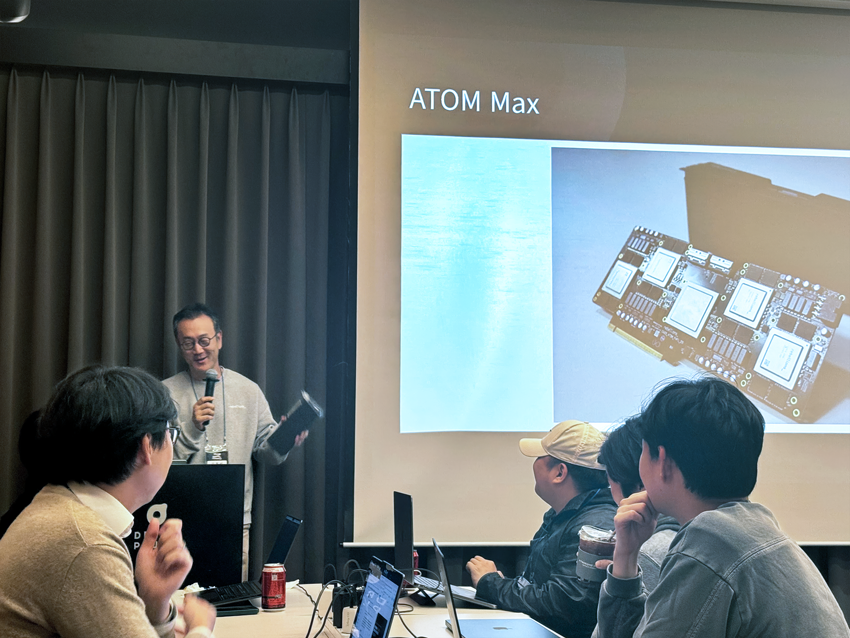

リベリオンは円滑に実習を行うために、ATOMTM NPUのサーバーを基盤として実習環境を構築しました。参加者はクバネティス(Kubernetes)を基にNPUのリソースプールに接続された個別のサーバーにアクセスして実習を行いました。

最初のセッションでは、PyTorchのEager Modeを利用した簡単なNPUを体験することから始まりました。参加者は、既存のGPU環境と同じコード構造となっており、ライブラリを別途で追加しなくても一行のコマンドだけでも、NPUでテンソル演算を実行することができました。それから、Hugging Face Transformersのライブラリをそのまま使って、Phi-3 0.6Bモデルをロードしたり推論したりしました。

次の段階では、プロダクション環境の性能を最適化するためにGraph Modeの実習が行われました。リベリオンプロファイラとPerfettoの可視化ツールを用いて、NPUの内部演算へのトレースを収集し、タイル単位のパイプライン構造をその場で確認することができました。参加者はPrefillとDecodeのグラフを別々にコンパイルし、Flash AttentionやKVキャッシュなど最適化したカーネルにより、Eager Modeに比べはるかに速い推論速度を体験できました。

vLLMのリベリオンNPUのバックエンドプラグイン

本ワークショップのポイントは、vLLMのリベリオンNPUのバックエンドプラグイン、つまり「torch.compile基盤のvLLM-RBLNフレームワーク」でした。プラグインはNPU上でPaged Attention、Continuous Batchingを実現し、実際のサービス環境で求められるメモリ効率および処理速度を最適化します。また、OpenAI APIと互換可能なEndpointを提供するため、開発者が既存のAPIワークフローをそのまま維持しながらも、リベリオンハードウェアの性能を利用できます。新たなハードウェアを導入しても、既存のコード資産や運用ノーハウを維持できることを、参加者が直接確認する機会となりました。

最後のセッションでは、Mixture-of-Experts(MoE)モデルを分散推論するデモが行われました。リベリオンNPU上では、Qwen1.5 MoEモデルを実行し、テンソル並列処理(Tensor Parallelism)とエキスパート並列処理(Expert Parallelism)の構造を結合した形でデモが行われました。今後リベリオンはvLLM-RBLN内のMoEへの対応を進めており、大規模な分散推論環境でもNPU基盤の性能向上と拡張性を持続的に強化していく計画です。

共に成長するオープンソースのAIエコシステム

今回のワークショップはただのデモではなく、クバネティスに基づいたプロダクション環境下の実習インフラ上で行われました。参加者はHugging Face、PyTorch、vLLMがリベリオンNPU上で自然に統合される体験をすることができました。これを機に、リベリオンとスクイーズビーツは今後2年間『vLLM Hands-on Workshop』を定期的に開催する予定です。韓国の開発者がvLLMを基にサービスを構築する経験ができるように実践的なサポートを提供していきます。これからもリベリオンは、開発者と共にオープンソースのエコシステムを広げ、NPUがAIインフラ内で安定的に普及すると同時に、より多くの開発者が活用できるように技術面での基盤を持続的に強化していきます。

Share This: